voriges Kapitel | nächstes Kapitel

4.2 Aufnahme

In diesem Kapitel wird die Aufnahme der verschiedenen Instrumente für das zugrundeliegende Werk beschrieben. Unter Aufnahme versteht sich die Übergabe der einzelnen Instrumentenspielinformationen an das Programm Cubase SX3, das auf dem Studiocomputer läuft. Grundsätzlich wird zwischen zwei verschiedenen Arten von Spielinformationen unterschieden: Audiodaten in Form von unkomprimierten PCM-Rohdaten, die wie in Kapitel 3.1 und 3.2 beschrieben gewonnen werden, sowie MIDI Daten, die Musik lediglich deskriptiv speichern und die Klangerzeugung jeweiliger dafür geeigneter Software oder Hardware überlässt. Da letztere Option eine immense Flexibilität mit sich bringt, wurde versucht, so oft wie möglich mit MIDI-Daten zu arbeiten, statt mit Audiodaten.

4.2.1 E-Schlagzeug

Die Aufnahme eines natürlichen Schlagzeuges beansprucht hochgesteckte Rahmenbedingungen, um einen akzeptablen Klang zu erzeugen, der sich mit anderen professionellen Musikproduktionen messen kann. Zuerst muß das Schlagzeug selbst entsprechend hochwertig sein, um überhaupt einen guten und satten Sound erzeugen zu können. Dann muß das Schlagzeug in einem angemessenen Raum aufgezeichnet werden, der möglichst reflektionsarm sein sollte. Dies hängt mit der Tatsache zusammen, dass Hall ohne Probleme der Aufnahme nachträglich hinzugefügt werden kann, aber bereits vorhandener Hall, der durch die Aufnahmeumgebung bedingt ist, kaum zu entfernen ist. Außerdem muß jede einzelne Trommel und jedes einzelne Becken mit hochwertigen Mikrofonen aufgezeichnet werden, die in einem entsprechend großen Mischpult auflaufen, um dort entweder direkt gemischt zu werden oder als Einzelspuren an ein entsprechend fähiges Aufzeichnungsgerät weitergegeben werden. Selbst wenn diese sehr aufwendigen Rahmenbedingungen gegeben sind, bedeutet dies noch nicht, dass die Aufnahme eines natürlichen Schlagzeuges befriedigend vollzogen wurde. Vielmehr sind die exakten Mikrofonpositionierungen in Relation zu ihren Schallquellen, sowie deren Ausrichtung in großem Maße entscheidend für den Klang. Eine wirklich gute Aufnahme eines natürlichen Schlagzeuges ist in der Regel erst nach vielen Jahren Erfahrung und mit entsprechend geschulten Ohren machbar.

Aus diesem Grunde wurde bei der Produktion des Songs „The Quest for Gold“ auf ein elektronisches Schlagzeug zurückgegriffen, das neben dem heutzutage sehr guten Klang auch noch andere Vorteile mit sich bringt, die im Rahmen dieses Kapitels noch angesprochen werden und ein hohes Maß an Flexibilität ermöglichen. Häger[5] drückt den Unterschied zwischen natürlichem Schlagzeug und E-Drums folgendermaßen aus:

„Im Gegensatz zum natürlichen Schlagzeug entstehen bei einem Edrum die Klänge nicht unmittelbar dort wo der Stock die jeweilige Spielfläche berührt. Vielmehr wird bei dem elektrischen Schlagzeug über spezielle Sensoren (so genannte Trigger) aufgezeichnet, wann, wie stark und wo welche Trommel (Edrumpads) angeschlagen wurde. Diese Information wird an ein so genanntes Steuerteil übermittelt, in dem aus einer Klangbibliothek ein abgespeicherter Klang geladen und abgespielt wird. Edrumpads und Edrumsteuerteile sind in sehr unterschiedlicher Qualität erhältlich und bieten deswegen sehr unterschiedliche Möglichkeiten.“

Diese Beschreibung erinnert stark an das MIDI-Format, das ebenfalls lediglich Informationen über Tonhöhe, Anschlagsstärke und Anschlagsdauer (sowie viele, viele weitere Instrumentenspieleigenarten) speichert und die eigentliche Klangerzeugung der jeweiligen Software auf dem entsprechenden Rechner überlässt. (Dies ist auch der Grund, wieso viele Menschen mit dem MIDI Format kaum gut klingende Pieptöne assoziieren: der mit den meisten Betriebssystemen mitgelieferte MIDI Synthesizer ist von einer sehr schlechten Qualität.)

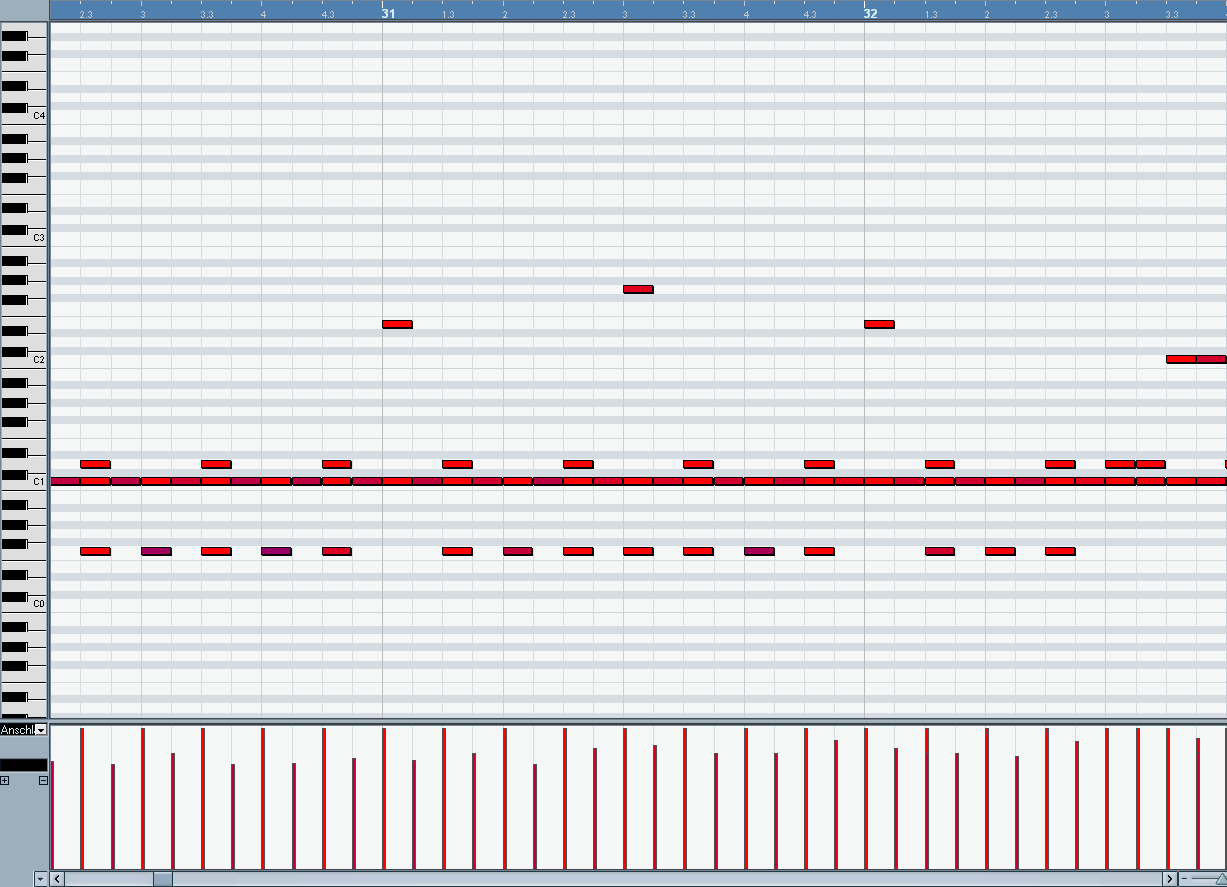

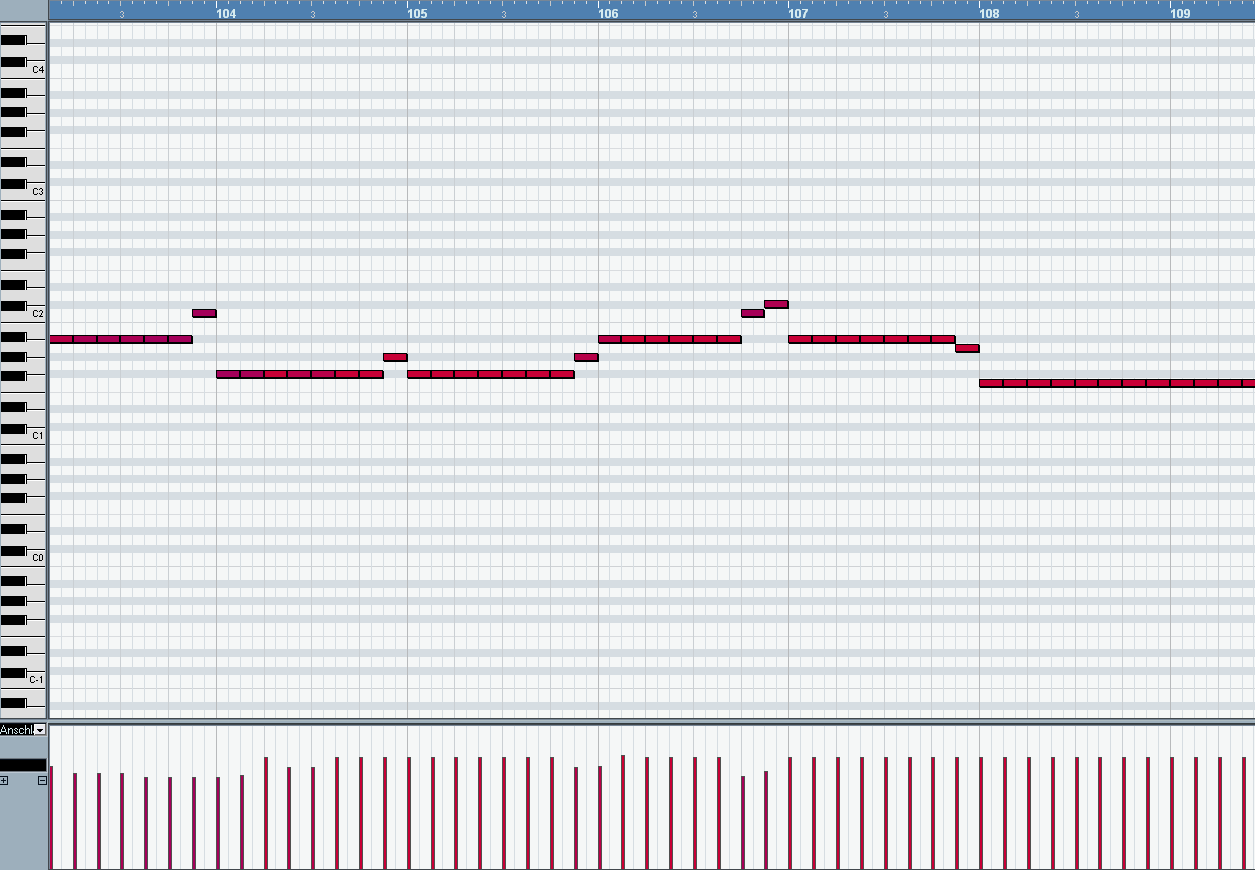

Tatsächlich ist es mit modernen E-Drum Steuerteilen möglich, diese Daten direkt an ein Audioaufzeichnungsprogramm wie Cubase zu übergeben. Abbildung 15 zeigt einen Ausschnitt der MIDI Schlagzeugspur in Cubase SX 3.

Abbildung 15: MIDI Schlagzeugspur in Cubase SX3

Im Hauptfenster des Cubase MIDI Editors sind die Aktivierungen (und aufgrund ihrer jeweiligen Länge ihre Deaktivierungen) der verschiedenen Trommeln in ihrem zeitlichen Verlauf zu erkennen. Verschiedene Trommeln korrespondieren mit verschiedenen Tonhöhen, wie die links angezeigte Klaviatur erahnen lässt. Beispielsweise liegt die Basedrum, die in diesem Beispiel (in der Strophe von „The Quest for Gold“) in durchgängigen Sechzehnteln gespielt wird, auf dem Ton C1 der Klaviatur und die Snare auf D1. Die jeweilige Stärke des Anschlages wird über die Farbe dargestellt: rot ist ein harter Anschlag. Je blauer, desto schwächer. Die Anschlagstärke, auch als Velocity bezeichnet, ist ebenso im unteren Fenster mit Balken dargestellt, die neben der Farbinformation auch durch ihre Höhe Aufschluß über die Anschlagstärke geben.

In einer MIDI Datei wären nun beispielsweise für Takt 31, Beat 1.1 lediglich eine Aktivierung der Basedrum (C1) und des Beckens (E2) gespeichert, sowie deren Deaktivierung bei Beginn von Beat 1.2. Zusätzlich würde die MIDI Datei noch Informationen über die Anschlagstärke besitzen. Diese Informationen werden später an einen Klangerzeuger geschickt, der das Schlagzeug dann hörbar macht.

In vielerlei Hinsicht ähnelt das MIDI Format also den Lochstreifen aus Papier, die bereits im 19. Jahrhundert Kunstspielklaviere (zum Beispiel Pianolas) zum Erklingen brachten.

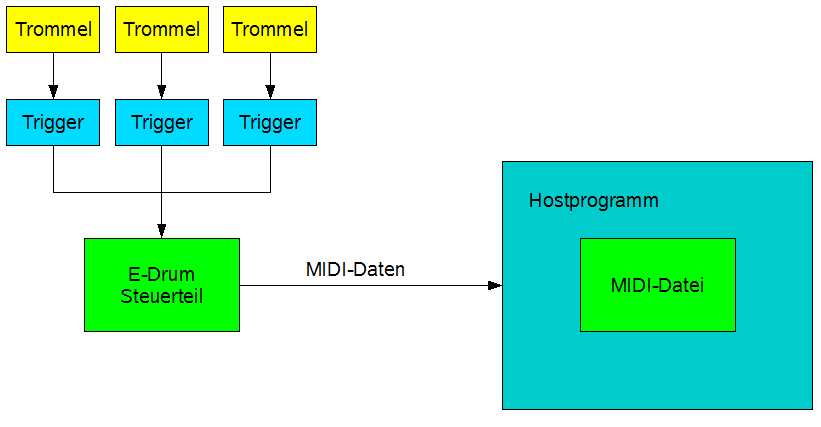

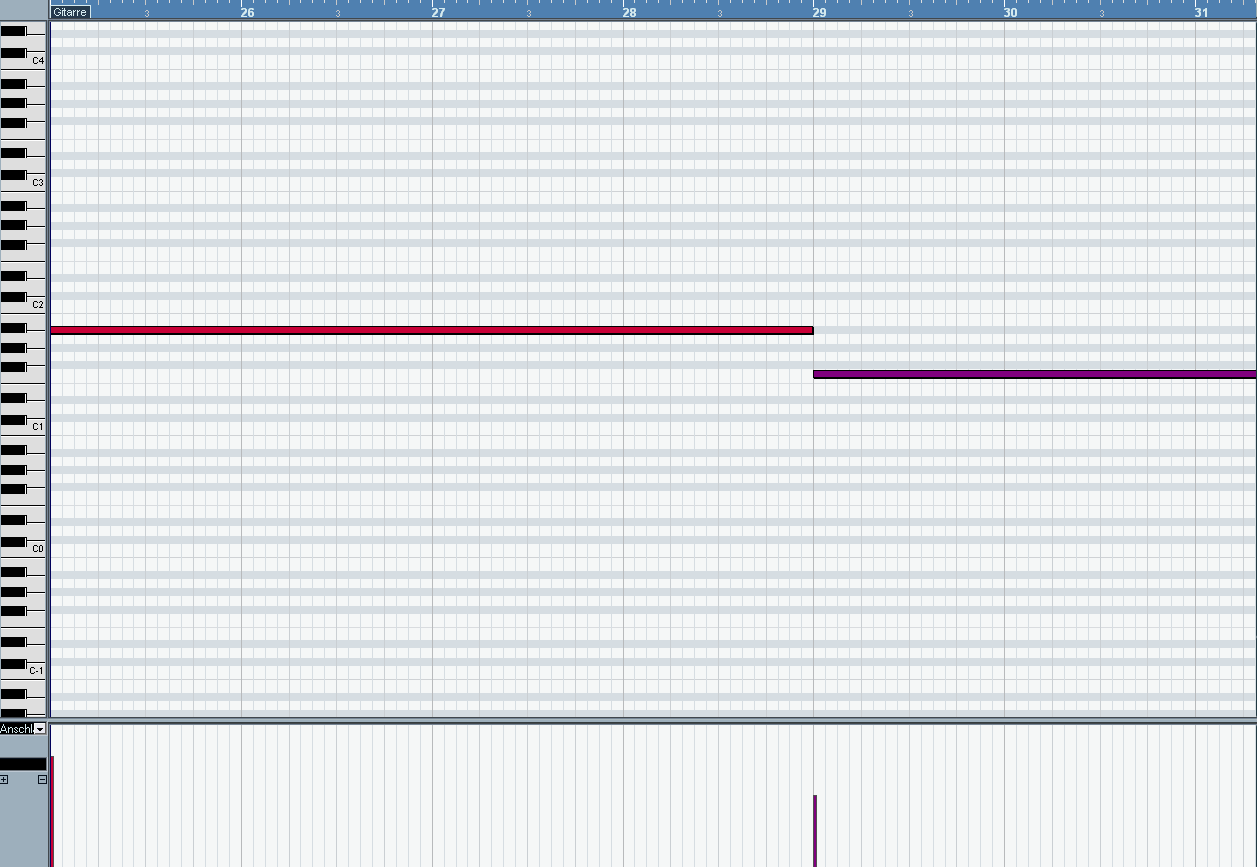

Abbildung 16 zeigt das Prinzip der Aufzeichnung einer MIDI-Datei in einem Hostprogramm (in unserem Falle Cubase SX3) mit Hilfe eines E-Drumsteuerteils:

Abbildung 16: Aufnahme einer Schlagzeug MIDI-Datei

Das Schlagzeug, das aus verschiedenen Trommeln besteht, wird von einem Schlagzeuger gespielt. Die Anschlaginformationen werden von Triggern aufgezeichnet, die an ein E-Drum Steuerteil angeschlossen sind und dort ausgewertet werden. Das Steuerteil erzeugt MIDI-Daten, die das Hostprogramm entgegennimmt und als MIDI-Datei auf die Festplatte schreibt.

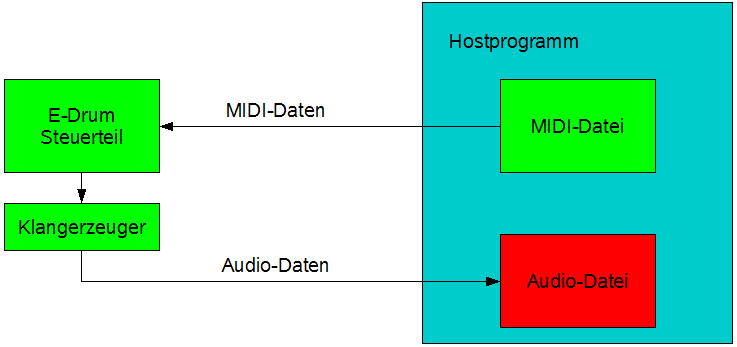

Diese MIDI-Datei muß später nun nicht zwangsläufig von einem Softwareklangerzeuger auf dem Computer in hörbare Toninformationen umgewandelt werden. In der Regel ist der Tonerzeuger in einem guten EDrumsteuerteil sehr hochwertig, da er auch bei Liveauftritten zur Anwendung kommen muß. Entsprechend kann man nun die zufriedenstellend bearbeitete MIDI-Datei später wieder an das E-Drumsteuerteil zurückschicken und so den eingebauten Klangerzeuger benutzen, um das Schlagzeugspiel hörbar zu machen. Abbildung 17 zeigt das Prinzip:

Abbildung 17: Aufnahme einer Schlagzeug Audiodatei aus MIDI Daten

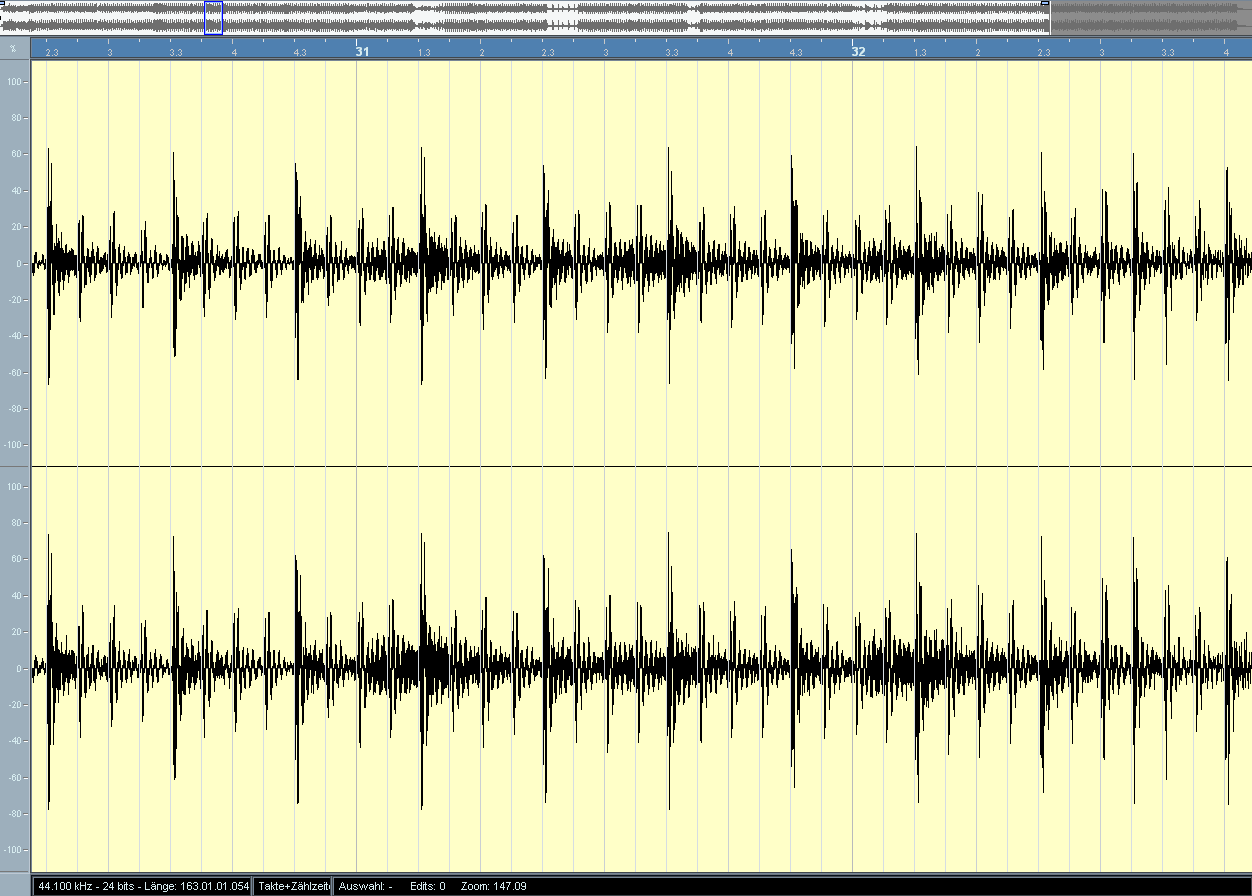

Das Hostprogramm sendet in diesem Fall nicht nur die MIDI Daten, sondern zeichnet auch die durch das E-Drumsteuerteil erzeugten Klänge auf eine eigene Audiospur auf. Dies muß deswegen gemacht werden, weil nicht jeder beteiligte Musiker ein E-Drumsteuerteil zur Verfügung stehen hat und Softwareklangerzeuger sich zu sehr in ihrem Klang unterscheiden können. Abbildung 18 zeigt die Audiodaten im Hostprogramm, als Ergebnis aus MIDI-Datei (Abbildung 15) und Klangerzeugung durch das E-Drumsteuerteil:

Abbildung 18: Audioschlagzeugspur erzeugt aus MIDI Daten

Die MIDI-Daten, die bereits im Studiorechner gespeichert waren, wurden somit in Audiodaten überführt, die auf jedem Musikcomputer gleich klingen. Dies wäre bei der MIDI-Datei aufgrund der unterschiedlichen Schlagzeugklangerzeuger nicht der Fall gewesen.

Die große Flexibilität der digitalen Audioproduktion liegt nun insbesondere in den dynamischen Eigenschaften der MIDI-Datei, die niemals einen fixen Status repräsentiert, sondern jederzeit mannigfaltig manipuliert werden kann. Insbesondere können in MIDI-Dateien explizit falsche Töne nachträglich (das heißt nach der Aufnahme) mit der Maus geradegerückt oder Teile, die nicht genau im Tempo liegen, angepasst werden. Dies bedeutet nicht nur weniger Fehlversuche bei den Aufnahmen (Audioaufnahmen müssen bei geringen Fehlern abgebrochen werden, da es kaum Möglichkeiten zur nachträglichen Korrektur gibt), sondern stellt auch weniger Ansprüche an die beteiligten Musiker.

Die Schlagzeugspur im Song „The Quest For Gold“ wurde so zum Beispiel gar nicht im Tempo 145 BPM eingespielt, sondern bei Tempo 110, was eine immense Erleichterung für den Schlagzeuger bedeutete. Die Geschwindigkeit wurde dann erst nachträglich erhöht, was auf den Klang der MIDI-Datei keinerlei Einfluß hat.

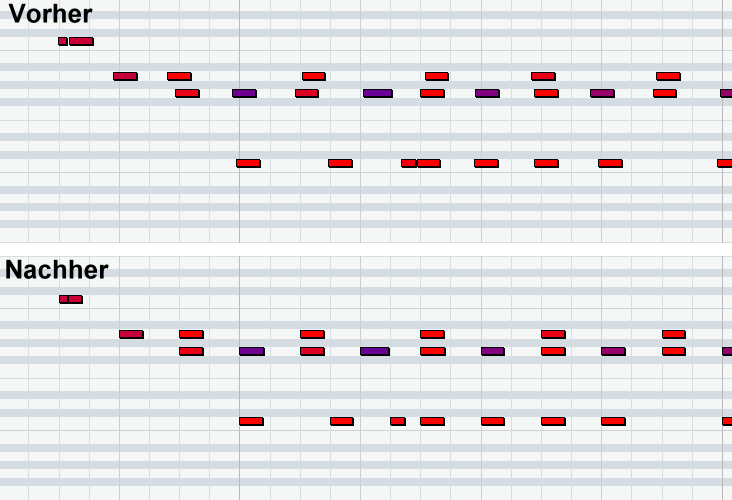

Trotz langsamerer Einspielgeschwindigkeit sind Menschen nicht präzise genug, um mehrere Minuten mit einem fixen BPM-Wert einzuspielen. Das ist auch der Fall, wenn man seine Aufnahme durch einen Klick (ein Metronom) begleiten lässt. Tatsächlich gibt es immer kleine Variationen im Tempo, die für den Menschen kaum hörbar sind, aber in einer MIDI Notation (zumindest optisch) auffallen. Diese Ausreisser kann man entweder von Hand auf die richtigen Taktstriche ziehen oder man quantisiert die Aufnahme, d.h. der Computer rückt die Noten automatisch auf die nächstliegenden Taktstriche. In Cubase SX3 startet man diese Funktion mit der Taste „Q“ im MIDI-Editor. Auf Grundlage der beiden Werte „Quantisierung“ und „Längenquantisierung“, die der Tontechniker vorgeben muß, kann der Computer so eine Abschätzung über die eigentlichen Positionen der Ereignisse innerhalb des Taktes vornehmen. Abbildung 19 zeigt eine MIDI-Datei vor und nach der Quantisierung (Quantisierung und Längenquantisierung stehen in diesem besonderen Fall beide auf 1/16):

Abbildung 19: Quantisierung einer MIDI-Datei

Erkennbar sind in der MIDI-Datei leichte zeitliche Variationen, die in der quantisierten Version nicht mehr auftreten. Es handelt sich also nach Anwendung einer Quantisierung um eine vom Timing her perfekte Aufnahme, die eine ausreichende taktgebende Grundlage für alle anderen Instrumente darstellt.

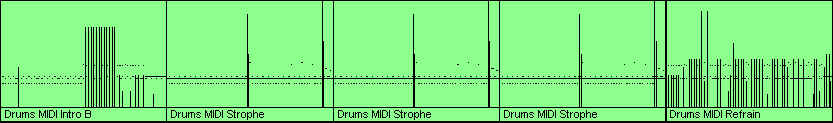

In Kapitel 4.1 wurde der Ablauf des Songs umrissen. Es bietet sich an, nicht den kompletten Song in einem Stück aufzunehmen, sondern immer nur Teile, die danach entsprechend dem Ablauf zusammengesetzt werden. Der Vorteil liegt in erster Linie in der Ersparnis des Arbeitsaufwandes. Außerdem müssen wiederkehrende Songpassagen, wie zum Beispiel der Chorus, nicht 9 mal gespielt werden, sondern nur einmal. Danach werden sie schlicht an die Stellen kopiert, an denen sie noch gebraucht werden. Abbildung 20 zeigt die zusammengesetzte Schlagzeug Midispur.

Abbildung 20: Zusammengesetzte Schlagzeugspur

Diese Sicht auf die verschiedenen MIDI-Dateien bietet das Cubase Projektfenster, in dem die verschiedenen Spuren untereinander angezeigt werden. Man erkennt das Ende der Intro, die Strophe, die 3 mal kopiert wurde und den Chorus/Refrain. Die Kopie von Songpassagen an andere Stellen ist nur dann möglich, wenn diese Passagen exakt im vorher festgelegten Tempo eingespielt wurden, so dass Übergänge flüssig genug sind, um nicht aufzufallen.

In diesem Kapitel wurde das Prinzip gezeigt, wie mit einem elektrischen Schlagzeug eine MIDI-Datei im Computer erzeugt wird und wie diese nachbearbeitet und dupliziert wird, um die komplette Trommelspur zu erhalten. Ebenfalls wurde gezeigt, nach welchem Prinzip aus dieser MIDI-Datei eine Audiodatei erzeugt wird, mit Hilfe des Klangerzeugers in einem E-Drum Steuerteil. Im nächsten Kapitel wird der Bass behandelt, der ohne externe Klangerzeuger auskommt - und ohne Bass.

4.2.2 MIDI Bass

Steht kein externer Klangerzeuger zur Verfügung, müssen die MIDI Daten auf andere Weise hörbar gemacht werden. Wie bereits erwähnt, sind die MIDI Synthesizer, die bei Betriebssystemen mitgeliefert werden, für gewöhnlich von sehr niedriger Qualität. Qualität versteht sich in diesem Fall als akustische Ähnlichkeit zwischen Klanggeber und dem natürlichen Instrument in einer optimalen Aufnahmeumgebung.

Für quasi alle Instrumente bietet der Markt Klangerzeuger auf Softwarebasis, die über das VST-Protokoll mit Hostprogrammen wie Cubase kommunizieren können. VST steht für Virtual Studio Technology und ist eine von der Firma Steinberg im Jahre 1996 veröffentlichte[6] Schnittstelle zur Kommunikation mit

den Klangerzeugern, den sogenannten VST-Instrumenten (VSTi). Neben Klangerzeugung auf Grundlage einer MIDI-Datei können VSTi auch Audioeffekte aller Art sein, die in Software nachgebildet wurden. Dazu in späteren Kapiteln mehr.

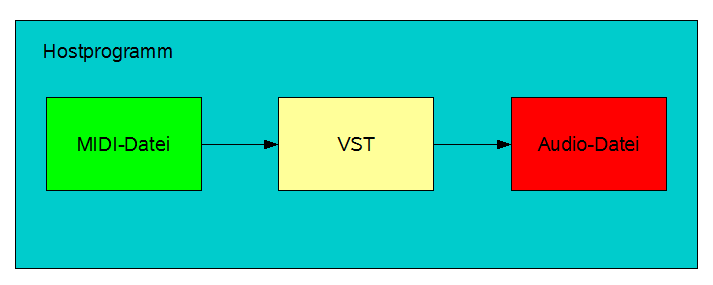

Abbildung 21 zeigt den Signalweg innerhalb eines Hostprogrammes wie Cubase.

Abbildung 21: MIDI Datei mit Softwareklangerzeuger

Die MIDI Daten werden in Echtzeit per VST Schnittstelle vom VST Instrument entgegengenommen (VST Schnittstelle und VST Instrument sind in der Abbildung als „VST“ zusammengefasst) und dort in hörbare Audioinformationen umgesetzt (hier als „Audio-Datei“ beschriftet, was nicht ganz der Realität entspricht, denn es besteht keine Notwendigkeit, die Ausgangsinformationen des VST direkt in eine Datei zu schreiben). Im Prinzip funktionieren alle Klangerzeuger gleich: für einen bestimmten MIDI Ton rufen sie in ihrer Datenbank einen entsprechenden Klang ab. Es gibt im Rahmen von VST Instrumenten, die echte Instrumente simulieren sollen, grundsätzlich zwei verschiedene Ansätze, die nicht unbedingt getrennt voneinander existieren müssen: zum einen basieren die Klänge auf tatsächlichen Aufnahmen von echten Instrumenten (sogenannten Samples), die andere Möglichkeit ist, die Klänge der Instrumente auf synthetische Weise nachzubilden. In der Regel gilt dabei, dass echte Sounddatenbanken im Gegensatz zu synthetisch erzeugten Klängen sehr viel Speicherplatz benötigen, aber auch sehr viel authentischer klingen.

Ein einfaches Rechenbeispiel veranschaulicht den benötigten Speicherplatz: würde man ein Konzertflügel mit 88 verschiedenen Tönen auf 7,25 Oktaven aufzeichnen wollen, so müßte man jeden einzelnen Anschlag einer Taste bis zum kompletten Ausklingen aufzeichnen. Nimmt man an, dass die Gesamtlänge der Töne von Anschlag bis Ausklingen ca. 5 Sekunden beträgt (außer acht gelassen, dass tiefe Töne naturgemäß länger ausklingen, als hohe), dann würde dies für eine Taste bei 96 kHz und 24 Bit ca. 1,4 MB Speicher in Anspruch nehmen. 88 Tasten entsprechen demnach 120 MB. In diesem Falle hat man aber noch kein brauchbares Klavier, da es in einem solchen Falle keine Anschlagdynamik gibt und jeder Ton gleich stark angeschlagen wird. Eine einfache Reduktion der Lautstärke für leichtere Anschläge mag zwar praktikabel sein, entspricht aber nicht dem Klang eines echten Flügels. Also muß jede der 88 Tasten noch mit unterschiedlichen Stärken angeschlagen werden. Nimmt man dafür nur drei verschiedene an (was sicherlich zu wenig wäre), errechnet sich schon eine Größe von 362 MB für die Sounddatenbank des VST Instruments. In dieser Rechnung sind die verschiedenen Klänge bei der Betätigung des Una Corda Pedals noch gar nicht eingerechnet. Ebenso müßte man das Sostenuto Pedal bei der Aufnahme beachten und gegebenenfalls weit länger als 5 Sekunden aufzeichnen. Viele VST Instrumente bieten darüberhinaus zusätzlich noch verschiedene Mikrofonpositionen und Klangfarben und erlauben den Wechsel zwischen wohltemperiertem und gleichstufigem Klavier. Ein Konzertpiano VSTi der Firma Steinberg namens „The Grand“ wurde bereits in seiner ersten Version auf 3 CDs ausgeliefert, was in etwa 2 GB Speicher entspricht. Das Chor VSTi „Symphonic Choirs“ der Firma East West, mit dem nicht nur Gesangsstimmen wie Bässe, Tenöre, Altos und Sopranos dargestellt, sondern sogar Wörter und Sätze geformt werden können, bringt es sogar auf 9 DVDs und damit 38 GB Speicherplatzanforderung.

Demgegenüber stehen VST Instrumente wie Edirols „Orchestral“, das mit 120 MB auskommt, aber ein komplettes Symphonie Orchester enthält (einschließlich Konzertpiano) oder „Slayer2“, das elektrische Gitarren mit nur 3 MB Speicherplatz simuliert. Hierbei handelt es sich naturgemäß um Synthesizer, die lediglich Klangcharakteristiken der entsprechenden Instrumente nachahmen. Zusätzlich gibt es eine in der Praxis übliche hybride Form, in der besonders charakteristische Klänge (bei Instrumenten in der Regel der Anschlag) als Sample vorliegen, andauernde, gleichförmige Klanginformationen aber dann entweder synthetisch angefügt oder in einer Schleife abgespielt werden.

Auch für den Bass gibt es eine Vielzahl von möglichen VST Instrumenten, so zum Beispiel Steinbergs „Virtual Bassist“ oder Spectrasonics „Trilogy“. Letzterer, der auch bei dem Beispiel zur Anwendung kam, benötigt 3 GB Speicher und bietet dafür neben einem akustischen und einem elektrischen Bass auch einen Synthesizerbass an. Insgesamt kann man in über 900 verschieden klingenden Bässen aller Arten wählen.

Im Beispielsong wurde der Bass nicht von Hand gespielt, da es schwierig ist, von Saiteninstrumenten MIDI Informationen zu erhalten. Zwar gibt es tatsächlich inzwischen entsprechende Effektgeräte für den E-Bass oder die E-Gitarre, die zusätzlich auch einen MIDI Ausgang besitzen, allerdings ist fraglich, ob sich dieser Aufwand im Rahmen der normalerweise überschaubaren Komplexität eines Basslaufes lohnt und inwiefern das MIDI Pendant nach seiner Digitalisierung noch Ähnlichkeit mit dem tatsächlichen Spiel des Bassisten hat. Sowohl beim Bass als auch bei der E-Gitarre gibt es über die reinen Toninformationen hinaus Geräusche, die von einem MIDI Umwandler wohl kaum umgesetzt werden dürften. Dazu gehören alle Arten von kurzen Quietschlauten beim Verschieben der Finger über die Saiten, sowie unterschiedliche Anschlagtechniken, wie zum Beispiel das Slapping, bei dem der Bassist die Saiten zum Schwingen bringt, indem er mit der Daumenwurzel daraufschlägt. Gute Bass VSTi stellen diese Geräusche selbstverständlich zur Verfügung, jedoch ist es unsicher, ob sie auch aufgerufen werden, wenn sie durch die MIDI Datei repräsentiert werden. Und wenn dies der Fall ist, so ist trotzdem nicht gewährleistet, dass das ursprüngliche Spiel des Bassisten Ähnlichkeit mit dem MIDI Endergebnis hat, das durch das VST Instrument geroutet wird. Alternativ könnte man wohl das entsprechende Effektgerät, ähnlich wie zuvor das E-Drumsteuerteil, als Klangerzeuger benutzen, jedoch wurde im Beispielsong ein VST Instrument benutzt.

Aufgrund dessen und weil der Aufwand in keinem Verhältnis zum Nutzen steht, wurde der Bass für den Beispielsong „The Quest For Gold“ mit der Maus im MIDI Editor des Hostprogrammes Cubase SX3 erstellt. Neben der Manipulation von vorhandenen MIDI Informationen bietet das Programm nämlich über eine entsprechende Schaltfläche (ein sogenannter „Stift“) die Möglichkeit, neue Töne zu erstellen. Diese werden an einer beliebigen Stelle mit einem Klick begonnen und so lange in der Partitur nach rechts hin vergrößert, bis sie die Wunschdauer haben. Wenn man dann die Maustaste loslässt, wird die Note mit einer festen Anschlagsstärke eingezeichnet. Da ein ständig gleichstarker Anschlag wenig natürlich erscheint, ist es empfehlenswert, einige bestimmte Töne mehr oder weniger zu akzentuieren, indem man im entsprechenden Manipulationsfenster am unteren Rand des MIDI-Editors die Höhen der Balken durch Drag and Drop einstellt. Abbildung 22 zeigt einen Ausschnitt des Basslaufes im Solo des Beispielsongs, der mit der Maus am Computer und ohne Instrument konstruiert wurde.

Abbildung 22: Basslauf im MIDI Editor

Neben dem Erstellen von Einzelnoten bietet der MIDI Editor von Cubase auch Arbeitserleichterungen, wie das Einzeichnen von Linien, die dann aus Einzelnoten der ausgewählten Quantisierungslänge bestehen. Aber auch Parabeln, Sinuskurven, Dreicke und Rechtecke können in die Partitur eingezeichnet werden, auch wenn diese aber in der Praxis eher von wenig Nutzen sein dürften.

Es bietet sich an, den Bass in ebenso kleinen Abschnitten zu erstellen, wie zuvor das Schlagzeug (siehe Abbildung 20), um auch hier einzelne Passagen nachträglich kopieren zu können.

Neben der beschriebenen manuellen Eingabe der Bassnoten, die dann über das VSTi Trilogy einem echten Bass zum Verwechseln ähnlich klingen, ist es natürlich auch möglich, einen MIDI Controller zur Eingabe zu benutzen. Ein MIDI Controller ist eine Hardwareklaviatur, die einen Ausgang für MIDI Signale besitzt und mit der Soundkarte des Studiocomputers auf dieselbe Weise verbunden werden kann, wie das E-Drum Steuerteil aus dem letzten Kapitel. Als Verbindungen haben sich für MIDI Datenkabel mit DIN Steckern der Norm 41524[7] durchgesetzt, in moderneren Geräten kommen aber auch USB Anschlüsse zum Einsatz, die einen entsprechenden MIDI Eingang am Computer überflüssig machen. Der Ablauf einer solchen MIDI Aufnahme wird in den nachfolgenden Kapiteln noch genauer beschrieben.

Der große Vorteil des MIDI Formats und der Klangerzeugung in Echtzeit ist nicht nur die nachträgliche Korrektur von Einzeltönen, wie bereits zuvor beschrieben, sondern auch die Manipulation des Klanges in vielen unterschiedlichen Arten. Abbildung 23 zeigt exemplarisch die mannigfaltigen Einstellungen, die im Bass VSTi Trilogy möglich sind und die Charakteristik des hörbaren Audiosignals signifikant ändern können.

Abbildung 23: Benutzerschnittstelle Trilogy VSTi

Die Beschreibung der einzelnen Einstellmöglichkeiten würde den Rahmen dieser Arbeit sprengen und kann der Anleitung des Herstellers entnommen werden. Die meisten VSTi bringen eine derartige oder sogar höhere Flexibilität mit sich. Der Benutzer kann während dem Abspielen der MIDI Daten Einstellungen vornehmen und die Ergebnisse sofort hören. Wie sich in späteren Kapiteln noch zeigen wird, kann das Hinzufügen oder die Änderung der Klangcharakteristik eines bestimmten Instrumentes Auswirkungen auf den Klang aller anderen Instrumente haben. So kann es möglich sein, bestimmte Frequenzen zu dämpfen oder zu verstärken. Dies ist auch mit entsprechenden Equalizereinstellungen in fest aufgenommenen Audiospuren machbar (siehe spätere Kapitel), jedoch nicht die nachträgliche Änderung des Instrumentes, des Verstärkers oder der Anschlagtechnik. Dies bleibt den VSTi vorbehalten.

Im Gegensatz zum Schlagzeug ist es bei der Bass MIDI Spur nicht nötig einen sogenannten Downmix (also eine Umwandlung von MIDI & VSTi zu Audio) vorzunehmen, da der Klangerzeuger nicht als Hardware, sondern als Software vorliegt und so stets bei Bedarf vom Computer angesprochen werden kann. Das E-Drumsteuerteil müßte zum Abspielen zunächst immer erst mit dem Computer verbunden werden, was spätestens dann Probleme verursacht, wenn mehrere externe Klangerzeuger zum Einsatz kommen.

4.2.3 Rhythmus E-Gitarren

Die Rhythmus E-Gitarren sind im Beispielsong sowohl VSTi, als auch echte Audioaufnahmen von E-Gitarren aus dem Studio. Die MIDI Daten für die VSTi wurden in ähnlicher Weise wie die Bass MIDI Daten erzeugt (also manuell per Maus). Das hier zur Anwendung gekommene VSTi nennt sich Virtual Guitarist und wurde von der Firma Steinberg entwickelt, ist aber inzwischen nicht mehr käuflich auf der Homepage des Herstellers beziehbar. Abbildung 24 zeigt das User Interface von Virtual Guitarist:

Abbildung 24: Benutzerschnittstelle Virtual Guitarist VSTi

Gitarren sind, im Gegensatz zu monophonen Instrumenten wie einem Bass, kaum bis gar nicht synthetisch nachzuahmen. Während außerdem die kleinsten Klangeinheiten von Instrumenten wie Klavier oder Schlagzeug grundsätzlich auch in Sampleform kombiniert werden können und daraufhin einen dem Originalinstrument sehr ähnlichen Ton erzeugen, ergeben zwei kombinierte E-Gitarrentöne bei einer echten E-Gitarre einen ganz eigenen Sound, der derzeit nicht an einem Computer erzeugt werden kann. Darüberhinaus gibt es, wie weiter oben bereits erwähnt wurde, sehr viele Zusatzgeräusche beim Spiel einer E-Gitarre, die sich ebenfalls künstlich nur sehr unzufriedenstellend reproduzieren lassen. Schlußfolgernd bedeutet dies, dass (E-)Gitarren VSTi wie „Virtual Guitarist“, sein rein elektrisches Pendant „Virtual Guitarist Electric Edition“ oder sein Nachfolger „Virtual Guitarst 2“ (alle von Steinberg), lediglich auf Samples basieren können. Dies bedeutet ebenfalls, dass Akustik Pickings oder E-Gitarrenriffs, die bei tatsächlichen Instrumenten aus mehreren Einzeltönen oder sogar schnell aneinandergereihten Akkorden bestehen, bei einem Gitarren VSTi als fertige Samples vorliegen, die zuvor vom Tontechniker ausgewählt werden und dann über einzelne MIDI Noten aufgerufen werden. Solche VSTi sind also nicht dazu geeignet, um beispielsweise in MIDI Noten einzelne Akkorde zu konstruieren und diese wiederzugeben, sondern enthalten stattdessen diese Akkorde schon in Sampleform. Anders ausgedrückt: MIDI Daten zur Steuerung eines VSTi wie Virtual Guitarist sind ausschließlich monophon. Die einzige Ausnahme bilden spezielle Kombinationen von parallelen Tönen, die lediglich signalisieren sollen, dass der entsprechende Akkord moll und nicht dur ist. Zur Verdeutlichung zeigt Abbildung 25 eine solche simple MIDI Information, die aus einer Spur des Beispielsongs stammt:

Abbildung 25: E-Gitarre im MIDI Editor

Hierbei handelt es sich um die ersten offenen (d.h. nicht abgedämpften) Akkorde des Songs. Man erkennt nur zwei lange Töne, nämlich A# und F. A# ist dabei stärker angeschlagen (rot), als das F (blau). Hörbar ist aber bei entsprechender Einstellung des VSTi ein A# Power Chord, der normalerweise aus den verzerrten E-Gitarrentönen A#, F und A#' besteht (respektive bei dem F die Töne F, C und F'). Interessant ist, dass präzise dieselben MIDI Informationen, die in Abbildung 25 zu sehen sind, später im Song dazu dienen, um gedämpfte 16tel Anschläge zu erzeugen. Dies ist deshalb möglich, weil eine andere Einstellung an dem VST Instrument vorgenommen wurde. Bei dieser Einstellung wird die MIDI Information lediglich anders interpretiert, nämlich als gedämpfte 16tel, die einmal mit einem akzentuierten Ton beginnen (wegen dem roten, harten Anschlag) und einmal nicht (blau). MIDI Daten gelten hier also nicht mehr als Noten für Klangerzeuger, sondern eher als einfachere Steuerdaten für ein vorgefertiges Arsenal an verschiedenen Riffs. Dieselben MIDI Daten würden bei einem Bass oder Klavier VSTi nur simple Einzeltöne erzeugen.

Entsprechend dieser Tatsachen sind die Samples eines Gitarren VSTis grundsätzlich sehr viel länger, denn sie enthalten nicht Einzeltöne, sondern ganze Spielarten. Andersherum sind die Daten, die sie erklingen lassen, viel einfacher, aber repräsentieren nicht die tatsächliche dahintersteckende Musik. Eine weitere Folgerung ist, dass die Sampledatenbank sehr viel größer ist, weswegen in Virtual Guitarist nur eine Oktave erzeugt werden kann. Dies ist allerdings wenig tragisch, denn auch Akkorde auf der E-Gitarre werden in aller Regel innerhalb der tiefsten Oktave gespielt.

Da ein solches VSTi nur eine begrenzte Datenbank aus einer überaus endlichen Anzahl von herkömmlichen Riffs und Pickings enthalten kann, ist ebenfalls offensichtlich, dass man bei ausschließlicher Benutzung von virtuellen Gitarren wohl kaum originelle Musik produzieren kann. Die Gitarren MIDI Spuren erfüllen also in erster Linie den Zweck, den Gesamtsound breiter zu machen und das Gitarrenspiel präziser wirken zu lassen. Tatsächlich ist es so, dass beispielsweise die oben erwähnten 16tel Anschläge von der Lautstärke her so weit runtergeregelt wurden, dass lediglich die zeitliche Präzision noch zu hören ist. Der Rest des Gitarrensounds für den Beispielsong „The Quest for Gold“ wurde nach herkömmlicher Weise aufgenommen und bildet die eigentliche Charakteristik des Gitarrenspiels.

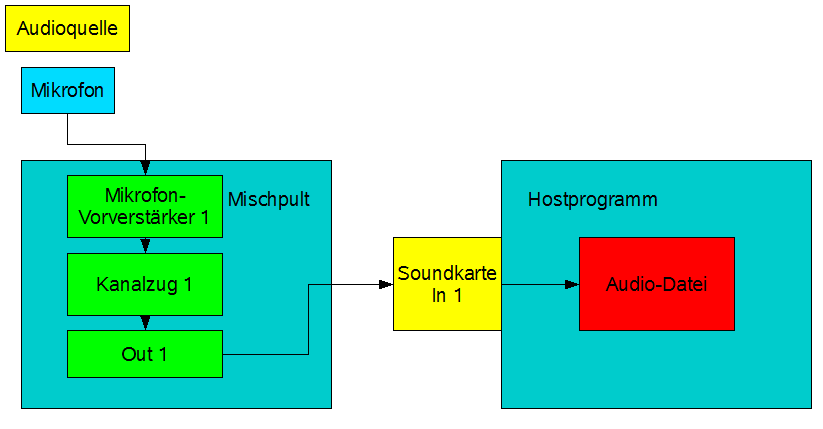

Im Beispielsong wurden insgesamt zwei Audiospuren für die Rhythmusgitarre aufgezeichnet. Abbildung 26 zeigt den grundsätzlichen Ablauf der Aufnahme einer Audioquelle im Studio:

Abbildung 26: Audioquellen Aufnahme

Eine Audioquelle wird über ein Mikrofon aufgezeichnet, das an einem Mischpult betrieben wird. Ein entsprechender, in jedem Kanalzug eines Mischpultes eingebaute Vorverstärker, versorgt das Mikrofon mit der dazu nötigen Energie. Das Signal liegt im entsprechenden Kanalzug an und muß nun gemäß den in Kapitel 3.2 gemachten Vorgaben gepegelt werden, d.h. es muß so ausgepegelt sein, dass es eine Übersteuerungsreserve von etwa -5 dB gibt, aber ansonsten die von der Soundkarte zur Verfügung gestellte Bittiefe optimal in Bezug auf die aufzuzeichnende Maximalamplitude ausgenutzt wird. Weiterhin verfügt das Mischpult über einen Signalausgang, der entweder pro Kanalzug vorhanden ist oder lediglich als Gesamtsumme des Pultes. Dieses Signal wird an den Eingangskanal der im Studiorechner eingebauten Soundkarte weitergegeben, die ihrerseits durch das Hostprogramm gesteuert wird. Dieses nimmt die Signale der Soundkarte am entsprechenden Eingangskanal entgegen und schreibt sie in eine Audiodatei. Je nach Audioquelle kann man auch mehrere Mikrofone parallel betreiben (wie zum Beispiel bei einer Schlagzeugaufzeichnung). In dem Falle würden die anderen Kanalzüge des Mischpultes zur Anwendung kommen und die einzelnen Audiosignale würden optimalerweise in separaten Soundkarteneingängen an das Hostprogramm übergeben werden. Anders ausgedrückt: würden 3 Mikrofone betrieben werden, so wäre es für spätere Mischarbeiten von Vorteil, wenn auch 3 separate Audiodateien vom Hostprogramm erzeugt werden würden. Dies setzt allerdings eine entsprechende Hardware voraus. Insbesondere die Soundkarte benötigt mehrere Eingänge und das Mischpult separate Ausgänge für jeden einzelnen Kanalzug.

Abbildung 27 zeigt die Positionierung des Mikrofons vor dem Gitarrenverstärker.

Abbildung 27: Positionierung des Mikrofons vor dem Verstärker

Neben der Aufzeichnung mittels Mikrofon und Gitarrenverstärker gibt es natürlich auch die Möglichkeit, die E-Gitarre (oder besser: den Ausgang ihres Effektgerätes) direkt über ein entsprechendes Kabel entweder mit dem Mischpult oder der Soundkarte zu verbinden. Allerdings geht dabei die spezielle Klangcharakteristik des Verstärkers (und dessen Lautsprechers) verloren, die in aller Regel erhalten bleiben soll.

Die Gitarrenspur wurde nun begleitend zu den bislang vorliegenden Instrumenten Schlagzeug, Bass und Gitarre (VSTi) insgesamt zweimal komplett aufgezeichnet. Zum einen, um einen volleren Sound zu erhalten und zum anderen, um die beiden Spuren etwas im Stereopanorama zu verteilen (dazu später mehr). Darüberhinaus können eventuelle Fehler, die bei der Aufnahme nicht aufgefallen sind, mit Hilfe einer zweiten Gitarrenspur gegebenenfalls retouchiert werden, ohne dass eine weitere Aufnahme im Studio nötig wird.

Das wichtigste Argument aber für eine zusätzliche E-Gitarrenspur, die mit einer echten E-Gitarre von einem richtigen Gitarristen eingespielt wurde, ist die oben genannte Tatsache, dass Virtual Guitarist und ähnliche Programme keinen Spielraum für Nuancen bieten. So fehlen spezielle Akzentuierungen des Anschlages, die auf das Schlagzeug an einer bestimmten Stelle passen ebenso, wie nicht herkömmliche Akkorde, außergewöhnliche Anschlagtechniken und die vormals schon genannten Zusatzgeräusche. Außerdem ist ein bestimmter Gitarrenklang oftmals eine Individualität, die natürlich mit einem VSTi ebenfalls nicht zu erreichen ist, da es sich um bereits vorher aufgezeichnete Samples handelt. Eine echte Gitarre unterscheidet sich aber im Klang anhand vieler Aspekte von einer anderen: die benutzten Saiten, das Alter dieser Saiten, die Wahl des Tonabnehmers, die Art des Tonabnehmers (Humbucker oder Single Coil), die Charakteristik des Halses und der Bünde, die Stimmung (die E-Gitarre im Beispielsong wurde auf D runtergestimmt), das verwendete Effektgerät mit unzähligen Einstellungen, sowie der benutzte Verstärker und dessen Lautsprecher. Diese speziellen Charakteristiken können naturgemäß von einem VST Instrument nicht erreicht werden. (Dies gilt selbstverständlich für alle Instrumente, jedoch wohl für kaum eines in einem derartigen Umfang, wie bei der E-Gitarre.)

Durch das Zusammenmischen sowohl der VSTi Gitarre, als auch der echten, erreicht man nun aber die Vorteile von beiden: die Präzision der MIDI-Gitarre und die Charakteristik der Audiogitarre. Dieser spezielle Sound muß nur noch in seinen Lautstärkeverhältnissen angepasst werden, was im Mix geschieht und in späteren Kapiteln beschrieben wird.

4.2.4 Solo E-Gitarren

E-Gitarren Soli lassen sich ebenfalls nicht authentisch per VST Instrument darstellen. Dem Autor sind keine Sampler oder Synthesizer bekannt, die einer Solo E-Gitarre in einem Maße ähneln, das dem Hörer keinen deutlichen Unterschied auffallen läßt. Entsprechend wurden die Solo E-Gitarren auch von Hand mit einer echten E-Gitarre eingespielt. Im Unterschied zu den Rhythmusgitarren wurde auf die Aufnahme via Mikrofon und Verstärker verzichtet. Stattdessen wurde direkt der Gitarreneffektgerätausgang mit einem Eingang der Soundkarte verbunden. Hochwertige Effekgeräte versprechen, verschiedenartige Verstärkerklänge simulieren zu können. Im tieffrequenten Bereich ist das Ergebnis zumeist unzufriedenstellend, aber im eher hochfrequenten Bereich eines E-Gitarrensolos fallen Verstärkercharakteristiken ohnehin weniger auf. Zusätzlich sei angemerkt, dass Verstärker gewöhnlicherweise Klänge verschlechtern, indem sie sie zum Beispiel dumpfer klingen lassen. Dies hängt damit zusammen, dass für E-Gitarrensound die Ära der Musikgeschichte charakteristisch ist, in der es keine hochwertigen Verstärker und Boxen gab. So schwören heute viele Musikliebhaber auf den dumpfen Klang eines Röhrenverstärkers. Ein Solo sollte aber einen möglichst reinen Sound besitzen, um sich vom Rest der Instrumentierung absetzen zu können, vor allem, wenn viele Instrumente gleichzeitig ein großes Maß an Frequenzbereichen belegt. Letztendlich ist dies aber eine Geschmacksfrage. Es wäre ebenso gut möglich gewesen, die Sologitarren wie die Rhythmusgitarren aufzuzeichnen.

Es wurden wieder zwei Spuren aufgenommen, die stets gleichzeitig zu hören sind und zu 90 Grad links und rechts im Stereopanorama verteilt sind. Zum einen erhält man als Ergebnis einen breiten Klang, zum anderen ist dies aber vor allem ein charakteristisches Merkmal: insbesondere in Passagen, in denen die beiden Gitarrenspuren sich leicht im Tempo oder in der Stimmung unterscheiden, entsteht der Eindruck von tatsächlich handgemachter Musik, der sicherlich im Rahmen der Präzision der oben genannten VST Instrumente als sehr angebracht erscheint.

4.2.5 Ambient

Wie in Kapitel 2.1 bereits erklärt, wird im Rahmen dieser Arbeit unter „Ambient“ jede Art von stimmungs- und klangfördernder Instrumentierung verstanden, die das Lied im Rahmen seines Arrangements nicht unbedingt nötig hat, aber dennoch entscheidend zum Klangbild beitragen kann. In der Stilrichtung des Power Metals sind dies oftmals Keyboards mit Synthesizer-Streichern oder sogar richtige Streicher, die schlicht die Grundakkorde des Songs begleiten. Eine solche Untermalung war für den Beispielsong ebenfalls geplant und es wurde sogar ein entsprechender Keyboarder beauftragt, allerdings wurden leider keine Ergebnisse abgeliefert (Musikermanagement wird in einem späteren Kapitel noch behandelt). Da der Song aber auch so bereits einen sehr breiten Klang aufweisen konnte, wurde dieser Plan später nicht weiterverfolgt. Die einzigen Streicher kommen nun im Refrain zum Einsatz.

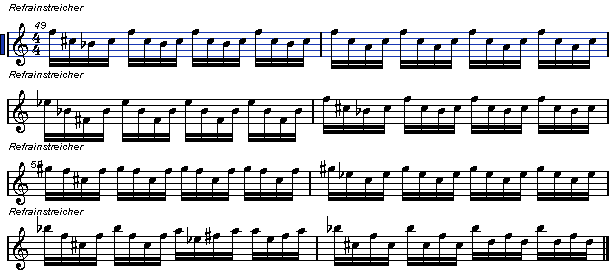

Diese Streicher spielen keine vollen Akkorde über ganze Takte, sondern sehr schnell gespielte Noten in der Strichart Spiccato, bzw. Sautillé. Die Noten werden in Abbildung 28 gezeigt und werden ausnahmsweise nicht in ihrer Darstellung im MIDI Editor von Cubase gezeigt, sondern in der Partituransicht. Dies hängt damit zusammen, dass es zuviele Noten sind und in der MIDI Ansicht kaum mehr als viele Punkte erkennbar wären.

Abbildung 28: Spiccato Streicher im Refrain

Diese Noten begleiten die Akkorde des Refrains, die die anderen Instrumente spielen und wurden, wie zuvor der Bass, per Maus in den MIDI Editor von Cubase eingegeben. Wiedergegeben werden sie vom VSTi Orchestral von Edirol in seiner Einstellung für mehrere Steicher, Strichart Spiccato. Diese Ambientpassage spielt in jedem der insgesamt 9 Refrains, wobei sie, wie alle anderen Instrumente, während der letzten 3 Refrains ausgeblendet wird.

Durch die Strichart und die Geschwindigkeit (bei 145 BPM) entsteht durch diese Passage eine beeindruckende Dramatik, die entscheidend zur Qualität und zum Charakter des Beispielsongs beiträgt.

4.2.6 Chor

In Kapitel 4.1 wurde der Einsatz eines Chores angesprochen. Es wurden mehrere verschiedene Ansätze hierzu verfolgt, die letzlich alle zu keinem Erfolg führten. Deswegen sind im fertigen Beispielsong kaum Chöre zu hören. Trotzdem sollen in diesem Kapitel die Vorgehensweisen beschrieben werden und der Grund für ihr Scheitern.

Ein synthetischer Chor begleitet auch in der finalen Version die letzten 6 Refrains. Es handelt sich hierbei um das VSTi „Magnus Choir“, das aber lediglich A-Laute wiedergeben kann und dies mit den entsprechenden MIDI-Daten auch eindrucksvoll tut – vor allem in Hinblick auf seine geringe Speicherplatzanforderung von in etwa 7 MB. Für die Stimmung an dieser Stelle ist dies sicherlich vorteilhaft. Auch ist dieser Chor das einzige Instrument, das bei der Instrumentalblende am Ende des Songs zusammen mit dem Gesang stehenbleibt. Für Profis und Musikkenner wird dieser Chor nicht sonderlich authentisch klingen, allerdings fügt er sich derart in den Gesamtkontext der anderen Instrumente ein, dass dies kaum auffallen sollte.

Darüberhinaus wurde probiert, einen artikulierten Chor, der die Worte „Hail King Anu“ an insgesamt 2 Stellen im Song dreimal wiederholt, hinzuzufügen. Dazu wurden drei Ansätze verfolgt. Einer mit tatsächlichen, menschlichen Sängern und zwei mit VSTi, die über eine immense Anzahl von Samples verfügen, darunter neben A-, E-, I-, O- und U- Lauten und anderen Vokalen auch die meisten geläufigen Konsonanten.

Die Aufnahme der menschlichen Sänger wurde immer und immerwieder in verschiedenen Tonlagen vorgenommen, um möglichst viele Gesangsstimmen zu erhalten. Diese wurden dann zusammengemischt und mit viel Hall versehen. Zwar klingt das Ergebnis durchaus zufriedenstellend, allerdings wirkt es im Gesamtkontext des Songs derart deplaziert, dass man es in der finalen Version des Beispielsongs nicht verwenden konnte.

Die beiden anderen Ansätze wurden mit den VSTi „Voices of the Apocalypse“ und „Symphonic Choirs“, beide von East West / Quantum Leap, verfolgt. Voices of the Apocalypse ist der Vorgänger der Symphonic Choirs und konnte nur kurz getestet werden. Die Bedienung, bzw. die MIDI Programmierung der einzelnen Worte ist derart kompliziert, dass in diesem Zeitraum kein brauchbares Ergebnis zustande kam.

Symphonic Choirs, das ausgiebiger getestet werden konnte, bietet ein vielversprechendes Tool, den sogenannten Word Builder, das die Formung verschiedener Worte sehr viel einfacher werden lässt. Technisch funktionert dies folgendermaßen:

Ein (Hardware) MIDI Keyboard sendet seine MIDI Daten an den Word Builder. Dieser ist im Wesentlichen ein Eingabefeld für (englische) Wörter. Eingegebene Silben werden in die korrespondierenden Längen der Einzellaute umgewandelt und gemäß den auf dem MIDI Keyboard gedrückten Tasten in bestimmte MIDISignale pro Silbe umgewandelt. Die verschiedenen Oktaven des MIDI-Ausgangssignals des Word Builder stehen nicht nur für verschiedene Tonhöhen, sondern auch für die unterschiedlichen Konsonanten. Dieses MIDI Signal kann nun von einem Hostprogramm wie Cubase normal entgegengenommen werden. Die MIDI-Daten sind entsprechend der darin enthaltenen Konsonanten und unterschiedlichen Vokale entsprechend komplex und in Ermangelung eines Word Builders für Voices of the Apocalypse ist es verständlich, dass keine brauchbaren Ergebnisse in kurzer Zeit erzielt werden konnten.

Zur Konstruktion der Wörter im Word Builder bieten die Hersteller nicht nur Englisch, sondern auch Lautschrift und Votox, eine extra für Word Builder geschaffene Sprache. Die Zeile „Hail King Anu“ würde sich in Votox folgendermaßen lesen:

Worte werden also in ihre Silben heruntergebrochen und mit bestimmten Groß- oder Kleinbuchstaben umschrieben. Großgeschriebene Konsonsten enthalten beispielsweise keine Tonhöheninformation (non-pitched), kleine (wie im Beispiel das g), werden in verschiedenen Höhen artikuliert (pitched). Vokale dagegen sind natürlich alle mit Tonhöheninformationen gespeichert. Das große E im Beispiel wird wie das deutsche I ausgesprochen, das O wie ein U. Es bedarf etwas Übung, um diese Sprache eingeben zu können, die merklich von englischsprachigen Menschen geschaffen wurde. Ein späterer Versuch, die Textzeile „Ki you ancient Tiamat; Mutilated by impact; Carry in your oceans sea; The remedy to our desease“ umzusetzen, erforderte folgenden Votox Text:

mO TE lA TeT baE Em PAKT

KA rE En yor o S!An SE

t!e r!Am A dE To au dE SES

Anhand dieses Beispiels sollte die Charakteristik der Votox Sprache deutlich werden. Pro Anschlag auf dem MIDI-Keyboard (dies können sowohl Einzeltöne als auch ganze Akkorde sein), wird nun jeweils eine Silbe wiedergegeben. So kann der Keyboarder selbst Tempo und Gesangsmelodie bestimmen. Im Word Builder kann auch entschieden werden, ob die Silben hart oder weich gesungen werden und ob die Konsonsten laut oder leise sein sollen.

Bei Symphonic Choirs hat man nicht nur die Wahl zwischen Bass, Barriton, Tenor, Alt, Mezzosopran, Sopran und Knaben, sondern kann auch Mikrofonpositionen, Gesangsvibrato und schier unzählige andere Einstellungen vornehmen. Dies alles resultiert in sehr hohen Anforderungen an den Computer, die im Rahmen der Arbeit am Beispielsong nur dann erfüllt werden konnten, wenn sonst keine anderen Programme oder VSTi geladen wurden. Symphonic Choirs wird auf 9 DVDs mit 38 GB Speicherplatzanforderung ausgeliefert und ein System mit 1,5 GB RAM war nur nach sehr langer Wartezeit fähig, die Wiedergabe in Echtzeit einigermaßen flüssig laufen zu lassen – allerdings nicht ohne den zweifachen Hinweis darauf, dass das Laden weiterer Samples auf eigenes Risiko geschieht.

Diese Tatsache macht die unbeschwerte Arbeit mit Symphonic Choirs mit der Computerhardware, die für den Test zur Verfügung stand, sehr träge. Ein Testergebnis klingt zwar alleinstehend beeindruckend und könnte durchaus als echter symphonischer Chor durchgehen, aber im Rahmen des Beispielsongs wirkte der Chor zu aufgesetzt und auch zu undeutlich in der Aussprache. Wörter können erahnt, aber nicht verstanden werden. Dies ist zwar bei Chören eher die Regel, aber nicht im Rahmen eines Musikstückes dieser Stilrichtung. Daher wurde auf den Gebrauch dieses Chores und die Anschaffung des VSTi (derzeit 500.- EUR) verzichtet.

Diese Fehlschläge haben zu dem Entschluß geführt, auf einen Chor im Beispielsong zu verzichten. Das erste Vorkommen von „Hail King Anu“ wird von einem normalen Sänger gesungen und das zweite Vorkommen wurde komplett weggelassen, zumal es sich um eine Stelle handelt, die sich bei genauerer Betrachtung im Nachhinein als zu hektisch für den Chor erwiesen hat.

4.2.7 Gesang

Die Qualität eines Songs steht und fällt mit der Stimme und dem Talent des Sängers. Bei keinem Instrument sind soviele Nuancen möglich, wie bei der menschlichen Gesangsstimme und noch weit mehr negative Teilaspekte einer Stimme können dafür sorgen, dass dem Hörer nicht gefällt, was er hört, womit wird der ganze Song als schlecht empfunden wird.

Zunächst ist zweifelsohne wichtig, dass der Sänger die Töne trifft, die er versucht zu singen. Aber ebenso muß er die Silben genau im richtigen Takt singen und die Töne halten können. Er muß Gesangsvibrato ebenso beherrschen, wie Falsett und Bass. Er muß Emotionen transportieren können, die in der jeweiligen Passage zum Text oder zur Melodie passen, d.h. seine Stimme muß „Gefühl“ besitzen. All diese Eigenschaften sind erlernbar, aber machen noch keinen guten Sänger aus.

Der Sänger muß eine angenehme oder zumindest passende Stimme besitzen, muß deutlich sprechen bzw. singen können, und darf nicht lispeln, krächzen oder stottern. Diese Eigenschaften sind nur bedingt erlernbar und deshalb kann man fast sagen, dass ein guter Sänger zum Sänger geboren sein muß. Wie sich in einem späteren Kapitel zeigen wird, kann die Tontechnik und im Speziellen die digitale Tontechnik einige der oben genannten Aspekte korrigieren. Aber eben leider nicht alle.

Aus diesem Grunde wurde für den Beispielsong nach 3 talentierten Sängern gesucht. Eine Suche nach einem guten Vokalisten ist nie einfach, vor allem im Hinblick darauf, dass für den Beispielsong kaum eine nennenswerte Bezahlung der Musiker stattgefunden hat. Insgesamt wurden 4 Sänger in Betracht gezogen, von denen lediglich 2 gut genug für die finale Version des Beispielsongs waren. Daher ist es leider unvermeidlich gewesen, dass ein Sänger zwei verschiedene Rollen belegt.

Zwei der Sänger, die später nicht in der finalen Version erschienen sind, wurden über ein soziales Netzwerk im Internet angesprochen, in dem vorher anhand ihrer Interessen der Rückschluß gezogen werden konnte, dass sie sich selbst als gute Metalsänger verstehen. Einer hatte seine Mitarbeit zwar immer fest zugesagt, aber niemals Ergebnisse geliefert, trotz einer deutlichen, anfänglichen Motivation. Nachfragen blieben unbeantwortet, wodurch sich der Sänger als unbrauchbar erwiesen hat, vor allem dann, wenn man bis zu einem gewissen Zeitpunkt die Zuarbeit der Musiker braucht, um den Beispielsong zu einem Stichtag fertigzustellen.

Der andere Sänger reiste 50 Kilometer mit dem Auto an und besang den kompletten Song. Diese Gesangsspuren, die es ebenfalls nicht in die finale Version geschafft haben, waren im Bassbereich anzusiedeln, was ganz explizit gegen die ursprüngliche Vorstellung des eher hohen Power Metal Gesangs verstoßen hat. Da zu diesem Zeitpunkt aber nicht absehbar war, ob noch bessere Sänger zur Verfügung stehen würden, wurde die Aufnahme komplett vollzogen.

Der dritte Sänger, der auf der Aufnahme in der Rolle des Cheruben 1 und 2 zu hören ist, ist der Sänger einer örtlichen Heavy Metal Band, die gewöhnlicherweise in tiefen und eher rauen Tönen spielt (und singt). Die Aufnahme wurde vom Sänger selbst in seinem eigenen Tonstudio ohne Anwesenheit des Autors dieser Arbeit aufgezeichnet und per E-Mail übersandt. Grundlage bildete die Demoversion, wie im Ablauf in Abbildung 7 zu sehen ist. Zusätzlich wurden Aufnahmen des Refrains in verschiedenen Tonhöhen mitgeliefert, die in der Endversion dazu beitragen, das Klangbild des Gesangs an jener Stelle zu verbreitern. Die Aufnahme ist, da es sich merklich um einen Profi handelt, überaus zufriedenstellend und mußte nur noch mit entsprechenden Effekten versehen werden. Dies wird in einem späteren Kapitel beschrieben.

Der vierte Sänger, der den größten Textanteil des „Enki“ hat und somit die Hauptrolle singt, ist ein kanadischer Freizeitsänger, der nicht nur über einen beeindruckenden Tonumfang und eine perfekt passende Stimme verfügt, sondern darüberhinaus Emotionen sehr gut transportieren kann. Ein zusätzlicher positiver Aspekt ist die Tatsache, dass seine Stimme der des bekannten Heavy Metal Sängers Bruce Dickinson (Sänger der Band Iron Maiden) gleicht. Der Kontakt wurde hergestellt, als der Autor dieser Arbeit die Idee hatte, die besten Sänger auf Online Karaoke Plattformen um ihre Mitarbeit zu bitten. Glücklicherweise mußte nur dieser eine Sänger befragt werden, der sogleich enthusiastisch zusagte. Online Karaoke Plattformen bieten ihren Mitgliedern kostenlos die Möglichkeit, instrumentale Lieder der Popmusik zu besingen und dies von den anderen Mitgliedern bewerten zu lassen. Durch die sprachliche Barriere und die große Entfernung erwies sich die Formulierung der Wünsche zwischen Kanada und Deutschland als schwieriger. Die gesamte Kommunikation fand über den Instant Messenger MSN statt, der in Amerika weiter verbreitet ist, als in Europa.

Zur Verdeutlichung der Anforderungen an den Gesang wurden deshalb vom Autor einzelne Gesangspassagen provisorisch besungen und per Skydrive (siehe

Kapitel 3.4) übermittelt. Dies fand für gewöhnlich gegen Abend deutscher Zeit statt, wodurch die Sounddateien in Kanada bereits morgens zur Verfügung standen (Deutschland ist diesem Teil Kanadas 7 Stunden voraus). Auf Grundlage dieser provisorischen Gesangsfragmente konnte der Enki-Sänger seinen Teil im eigenen Tonstudio aufzeichnen und (abends kanadischer Zeit) zurücksenden, wodurch das Material früh morgens in Deutschland bereits zur Verfügung stand. In diesem Hinblick erweist sich eine Zeitverschiebung sogar als sehr effektive Arbeitsbeschleunigung.

Die verlustfreien WAV Dateien wurden dann einfach in das Cubase Projekt des Beispielsongs importiert.

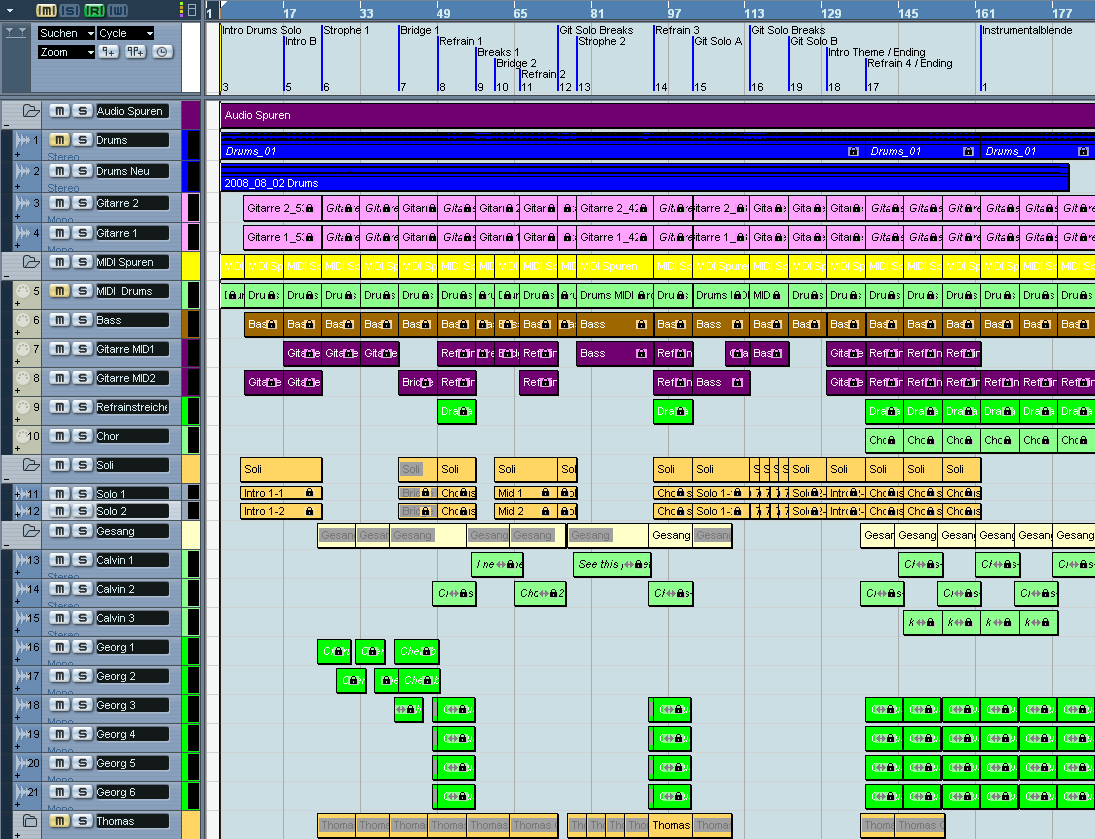

Mit dem Gesang wurde die letzte Spur dem Gesamtprojekt hinzugefügt. Abbildung 29 zeigt eine Übersicht im Programm Cubase SX3.

Abbildung 29: Gesamtprojekt im Cubase Projektfenster

Ganz oben befindet sich die Benennung einzelner Passagen, damit sich Musiker autark im Projekt hätten zurechtfinden können. Darunter folgt ein Überordner für Audiospuren, in dem eine erste Schlagzeugspur (im Beispiel stummgeschaltet) und die finale Schlagzeugspur zu finden sind, sowie die beiden mit Mikrofon aufgezeichneten Rhythmusgitarrenspuren.

Darunter folgt ein Unterordner mit MIDI Spuren, worin von oben nach unten enthalten sind: Trommelspur (stumm, da Audiospur vorhanden), Bass, Gitarre 1 (16tel), Gitarre 2 (volle Akkorde, Streicher (die nur im Refrain zum Einsatz kommen) und der Chor (nur in den letzten 6 Refrains).

Danach folgt ein Solo-Ordner, der, wie weiter oben beschrieben, zwei Gitarrensolospuren enthält.

Zuletzt folgt der Gesangsordner, der zunächst den kanadischen Sänger auf 3 Spuren enthält, danach den deutschen Sänger der lokalen Heavy Metal Band in 6 Spuren und schlußendlich der Sänger, der im sozialen Netzwerk angesprochen wurde, aber leider im Bassbereich gesungen hat (ebenfalls stummgeschaltet).

Erkennbar an dieser Ansicht ist vor allem der Aufbau einzelner Spuren, die in erster Linie aus kleinen Abschnitten zusammengesetzt wurden. Dieser konstruktivistische Ansatz unterscheidet sich deutlich von klassischen Audioproduktionsparadigmen, in denen Musiker dazu gezwungen waren, größere Abschnitte am Stück spielen zu können. Dieser Anspruch entfällt weitgehend im Rahmen des bislang gezeigten Vorgehens.

Zwar ist zu diesem Zeitpunkt das komplette Beispielsong aufgezeichnet, aber er klingt noch nicht gut genug. Deshalb wird im nächsten Kapitel beschrieben, wie und welche Postmanipulationen vorgenommen wurden.

voriges Kapitel | nächstes Kapitel